(1)数据获取;本文中数据的获取方式是直接获取外卖配送分析及可视化分析。

(2)数据清洗:本文数据清洗使用的是python语言,通过pycharm读取数据文件,并入库操作。在入库之前,剔除无用字段、标准化处理。

(3)数据分析:在数据库中使用sql语言多维度排序分析。

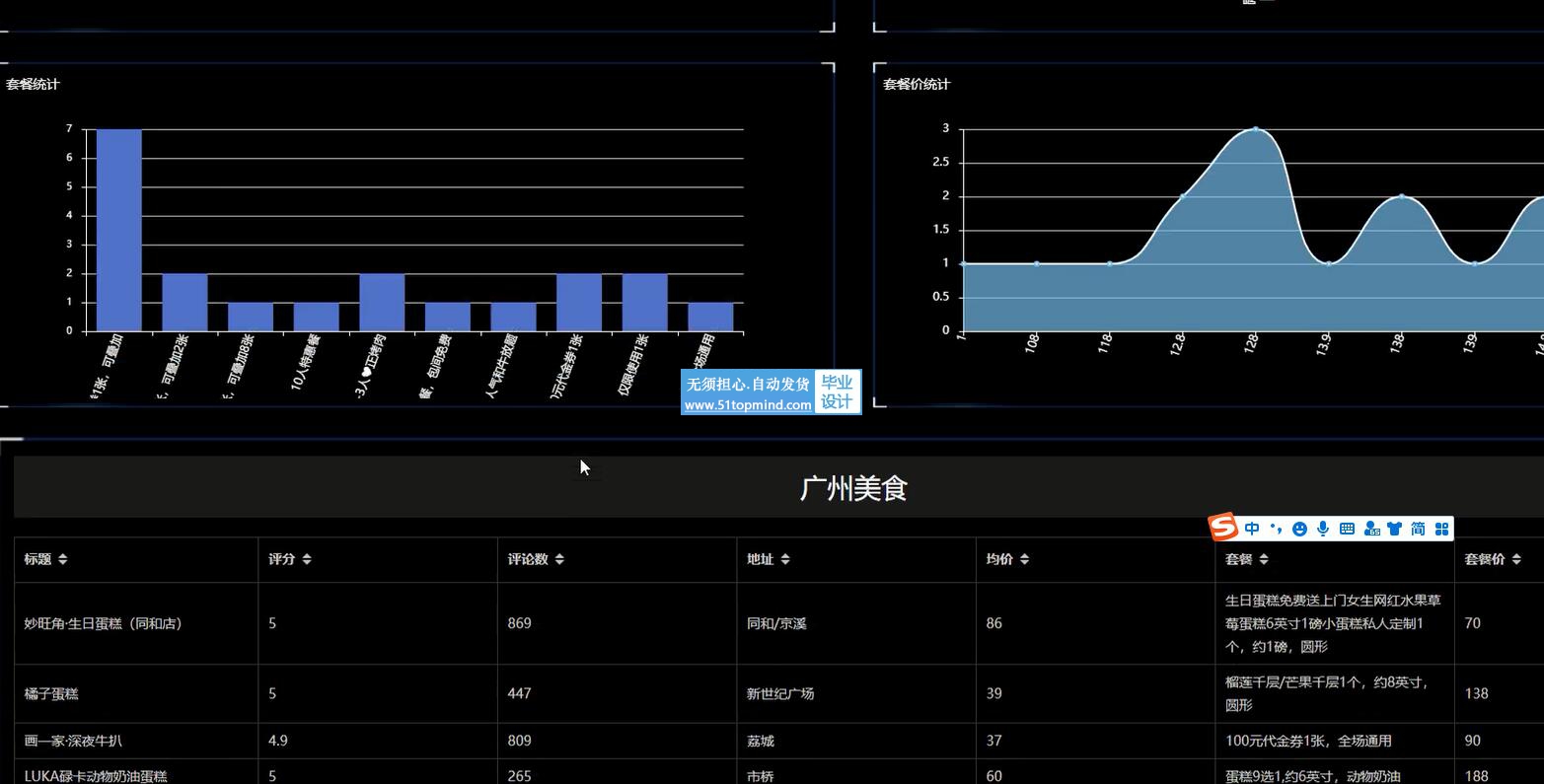

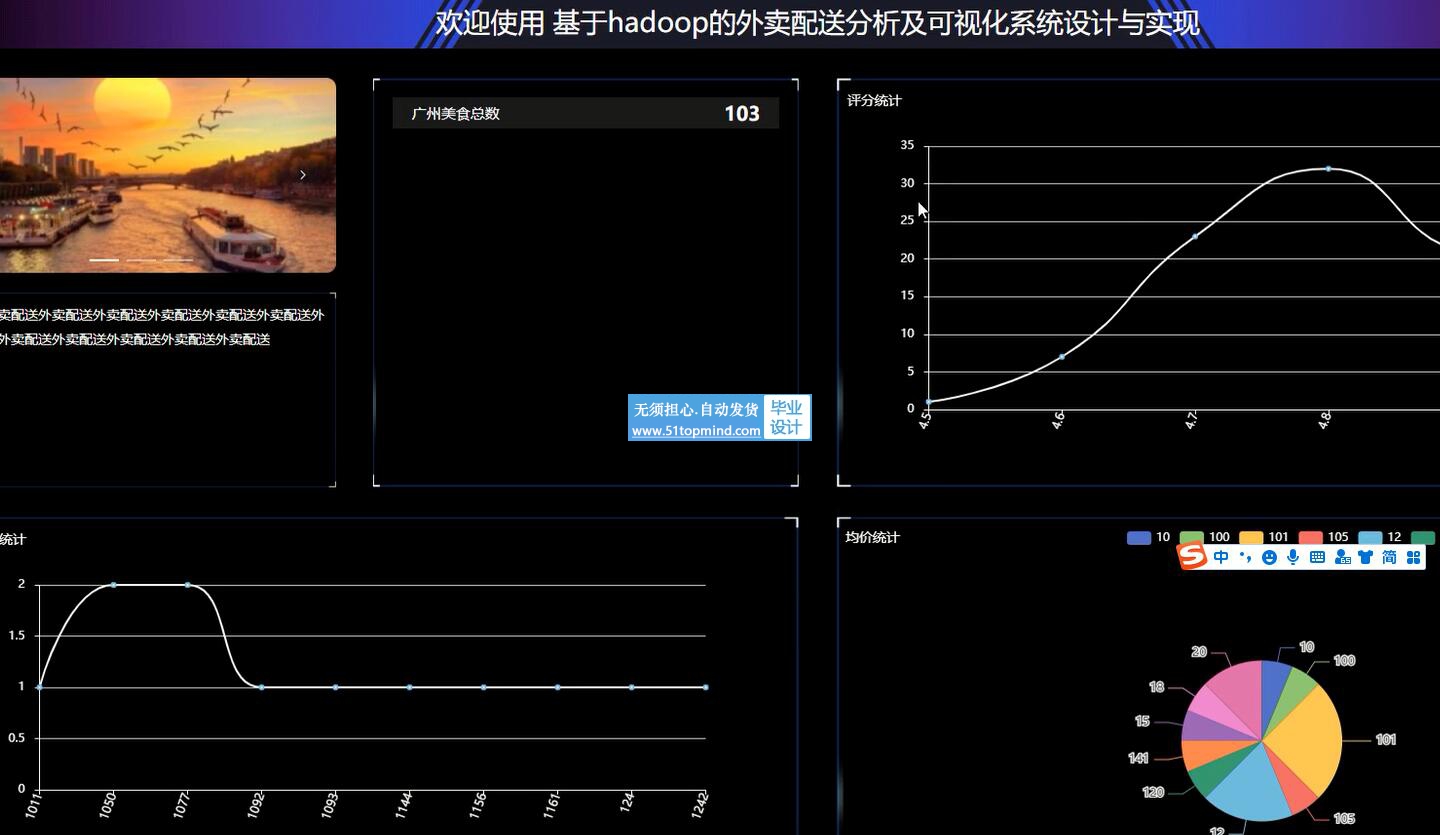

(4)分析结果展示与说明:将分析结果通过python绘制趋势图可视化展现。

本课题使用Python语言进行开发。基于web,代码层面的操作主要在PyCharm中进行,将系统所使用到的表以及数据存储到MySQL数据库中

技术栈

后端:python

前端:vue.js+elementui

框架:django/flask

Python版本:python3.7+

数据库:mysql5.7

数据库工具:Navicat

开发软件:PyCharm .

(1)数据获取板块

数据获取板块功能主要是依据分析目的及要达到的目标,确定获取的数据种类,并使用直接获取数据文件方式或爬虫方式获取原始数据。

(2)数据预处理板块

数据预处理板块功能是对获取到的数据进行预处理操作:将重复的字段筛选,将过短并且没有实际意义的数据进行过滤,选择重要字段,标准化处理,异常值处理等预处理操作。

(3)数据存储板块

数据存储板块主要功能是把经过预处理的数据持久化存储,以便于后续分析。

(4)数据分析板块

数据分析板块主要功能是根据分析目标,找出数据中字段之间的内在关系,与规律。

(5)数据可视化板块

数据可视化板块主要功能是使用适当的图标展现方式,把数据的内在关系、规律展现出来。

随着社会的不断发展,互联网数据时代的到来,数据的背后是什么,数据有什么用,怎么用庞大的数据来呈现出数据的价值,让我们一起去揭开它神秘的面纱。

本次以外卖配送分析及可视化系统爬取为例,介绍网络爬虫的基本原理,Python环境的搭建,PyCharm scrapy模块的爬虫数据的运用,把获取到的数据进行清洗、整合,储存数据到MySQL,然后进行数据可视化的呈现,简单对呈现的图进行数据分析。

关 键 词:Python;MySQL;PyCharm;爬虫;数据分析;数据呈现。

目录

摘要 I

Abstrac II

1 绪论 1

1.1 背景及意义 2

1.1.1 背景 3

1.1.2 目标及意义 3

1.2 应用现状 4

1.3 主要板块 4

1.4 主要方法及技术路线 5

1.4.1 主要方法 5

1.4.2 技术路线 6

1.4.3实现途径 7

2开发环境及技术 8

2.1 软件硬件设备 8

2.1.1 其他 9

2.2 开发环境与工具 10

2.2.1 Python简介 10

2.2.2 爬虫简介 11

2.2.3 Django框架简介 12

2.2.4 MySqL数据库 13

2.2.5 hadoop简介 14

2.2.6 hive简介 14

3 可行性分析与模块设计 15

3.1 可行性分析 15

3.1.1 技术可行性分析 16

3.1.2 数据可获得性分析 17

3.2 各功能模块设计 18

3.2.1 数据获取方法 19

3.2.2 数据预处理设计 20

5 系统设计 22

4.1系统功能结构图 21

4.2系统数据库设计 21

4.2.1数据库E-R图 21

4.3数据库表结构 21

5 系统实现与结论 22

5.1 用户功能的实现 22

5.2管理员功能的实现 23

5.3数据可视化分析看板展示 25

5.4 结论 26

6总结 29

致 谢 30

参考文献 31